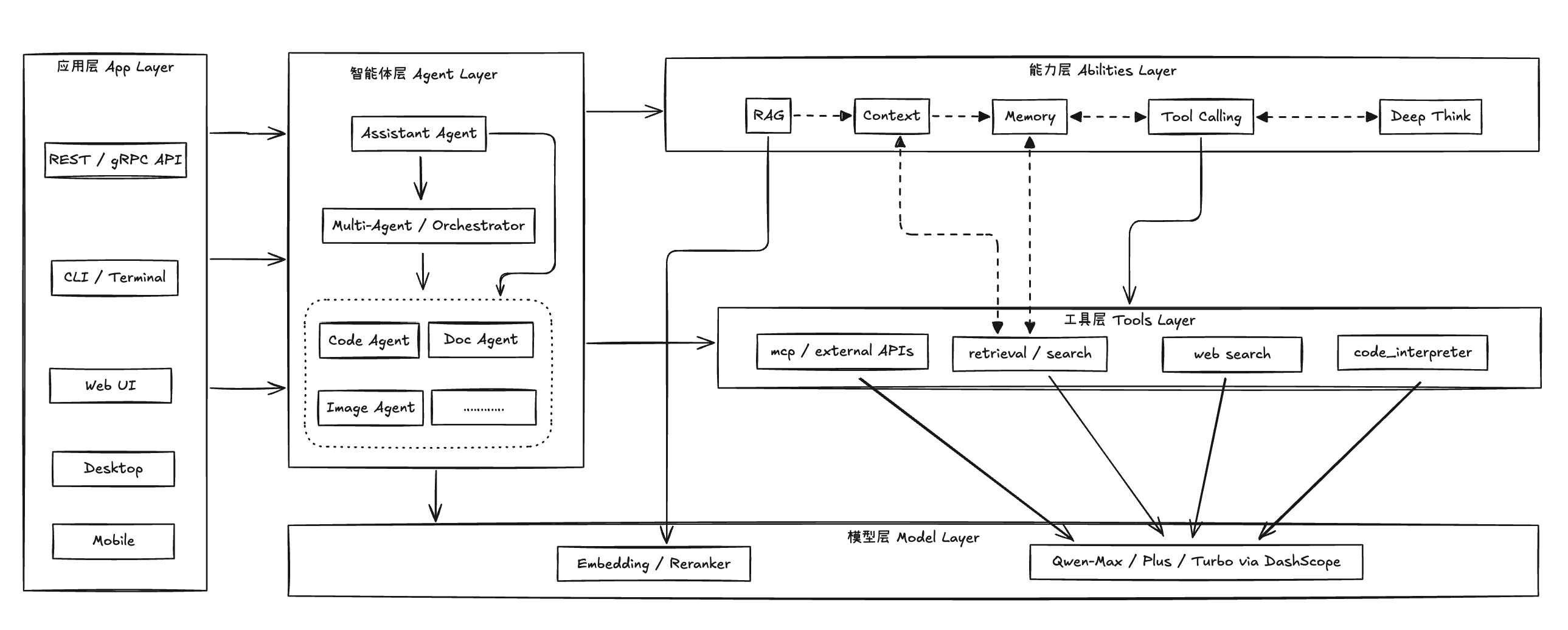

Qwen-Agent 多 Agent 路由架构说明

1. 设计目标与整体思路 Qwen-Agent 路由层(Router)的核心目标是: - 将多种能力(对话 / 图片 / 代码 / 文档 / 工作流)统一暴露为 单一入口 - 让 LLM 自动决策使用哪个 Agent - 保证多轮对话中...

记录技术与随想

Latest drops

1. 设计目标与整体思路 Qwen-Agent 路由层(Router)的核心目标是: - 将多种能力(对话 / 图片 / 代码 / 文档 / 工作流)统一暴露为 单一入口 - 让 LLM 自动决策使用哪个 Agent - 保证多轮对话中...

📘 Qwen-Agent 框架架构解析 对应源码仓库: https://github.com/QwenLM/Qwen-Agent 文档包含架构图、循环图、多 Agent 协作图、Memory RAG 数据流图、工具体系图与异常处...

How to Run Ollama on Linux with AMD MI50 Tested Environment: Ubuntu 22.04 --- Quick Start Summary bash 1. Install R...

今年以来,科技圈里最火的莫过于 DeepSeek 的横空出世了,无疑是震惊中外的一个突破

前情提要  2023 年 6 月 6 日凌晨,苹果在 WWDC23 ...

小伙伴们新年好啊,颓废的 2023 年总算是过去了,过去这一年因为自己的状态不太好,一直也没怎么更新,2024 年是时候...